Automatisiertes Fahren: Kamera läuft!

Sie bringen den Autos das Sehen bei: Matthias Birk und Andreas Schulz haben eine Kamera mitentwickelt, die dank KI noch zuverlässiger Objekte erkennt. Ein Job zwischen herausfordernder Theorie und spannender Praxis.

Wie die Vision vom automatisierten Fahren Wirklichkeit werden kann

Ein klarer Blick für die Gegenwart kann gleichzeitig sehr zukunftsweisend sein. So ist das zumindest bei Matthias Birk und Andreas Schulz: Die beiden Bosch-Entwickler arbeiten an der Multifunktionskamera MPC3. Durch sie erkennen Fahrzeuge ihre Umgebung schneller und zuverlässiger als bisher. Die Kamera hilft, bestehende Probleme bei der Umfelderkennung zu lösen – und treibt damit die Entwicklung hin zum automatisierten Fahren voran.

Besser als das menschliche Auge

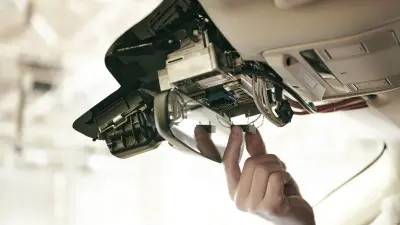

Gemeinsam mit weiteren Kollegen koordinierten Birk und Schulz als Projektleiter rund 20 Teams, die an der Entwicklung der Kamera beteiligt waren. Bei ihnen bündelt sich das Wissen und die Verantwortung – die Aufgabe ist groß. „Das Auto soll zum besseren Fahrer werden. Deshalb muss die Technik noch zuverlässiger arbeiten als der Mensch“, sagt Birk. Die MPC3 schafft das bereits: „Wenn der Mensch etwas sieht, heißt das nicht, dass er es auch richtig erfasst“, sagt Schulz. Die Videokamera für das Auto, die zwischen Dachhimmel und Rückspiegel hinter der Windschutzscheibe sitzt, sorgt dagegen sofort für die richtige Reaktion auf das Geschehen. Zudem ermüdet sie nie und funktioniert selbst nach längerer Fahrt noch wie auf den ersten Kilometern.

„Wir brauchen jetzt keine Fahrbahnmarkierung mehr, um das selbstfahrende Auto sicher auf der Straße zu halten.“

Fährt sicher – und bremst alleine

Wenn Birk und Schulz auf der Teststrecke beim Bosch-Standort Renningen die Funktionen der Kamera präsentieren, flimmern bunte Formen und Flächen über den Monitor im Cockpit. Die Multifunktionskamera erfasst das Geschehen während der Fahrt und verarbeitet die Informationen blitzschnell: Das Auto legt selbstständig eine Vollbremsung vor einem Hindernis ein.

Meilenstein mit KI

Dass die MPC3 einen großen Schritt auf dem Weg zu autonom fahrenden Autos ermöglicht, liegt vor allem auch am Einsatz von künstlicher Intelligenz. Dazu hat das Bosch-Team einen Multipfad-Ansatz entwickelt: Die von den Ingenieuren und Programmierern erschaffene Software-Architektur in einem hochleistungsfähigen System-on-Chip (SoC) mit integriertem Mikroprozessor verbindet klassische Bildverarbeitungsalgorithmen mit Methoden der KI. „Das ermöglicht ein bislang unerreichtes Szenenverständnis und zuverlässige Objekterkennung“, sagt Schulz.

Drei Pfade für ein sicheres Ergebnis

Die 12 x 6,1 x 3,6 Zentimeter große MPC3 arbeitet mittels dreier Pfade für Objekterkennung.

Pfad 1: Klassifikator

Der erste Pfad wird bereits heute genutzt: Mit maschinellem Lernen werden Klassifikatoren trainiert, um dedizierte Objekte wie Fahrzeuge und Fußgänger im Bild erkennen und klassifizieren zu können.

Pfad 2: Optischer Fluss

Im zweiten Pfad nutzt die Kamera den optischen Fluss und die sogenannte Structure from Motion (SfM), um erhöhte, die Fahrbahn begrenzende Objekte wie zum Beispiel Bordsteine zu erkennen. Aus zusammengehörigen Bildpunkten, die in ihrer Bewegung nachverfolgt werden, errechnet die Kamera dreidimensionale Strukturen.

„Zudem ist die Auflösung der Bilder so hoch wie nie, statt rund einem Megapixel haben wir rund 2,5“, sagt Birk. „Dadurch lassen sich Objekte noch früher und präziser erkennen.“ Gleichzeitig wurde der Sichtwinkel auf insgesamt rund 100 Grad erhöht. „Das ist mehr, als wir Menschen im Normalfall bei fokussiertem Blick scharf sehen können“, so Birk.

Pfad 3: Künstliche Intelligenz

Der dritte Pfad greift auf künstliche Intelligenz zurück. Die neue Generation der Multifunktionskamera kann über neuronale Netzwerke und semantische Segmentierung – also die Zuordnung jedes Pixels eines Bildes zu einer definierten Kategorie – Oberflächen der Fahrbahn und des Fahrbahnrandes oder Objekte erstmals voneinander unterscheiden.

Ein riesiger Vorteil: „Wir brauchen jetzt keine Fahrbahnmarkierung mehr, um das Auto sicher auf der Straße zu halten“, so Schulz. Durch die Kombination der Detektionspfade können Fehler noch besser vermieden werden.

Agile Projektstruktur als Trumpf

Die Spur halten – das galt im übertragenen Sinne auch für das anspruchsvolle Projekt in der Entwicklungsphase. „Wir wollen schnell auf Änderungen reagieren können“, sagt Schulz, „deshalb ist es uns wichtig, dass wir sehr flexibel arbeiten.“ Die Projektleiter koordinieren eigenverantwortlich arbeitende Teams über jeweilige Ansprechpartner. Kein Tag ist im Vorfeld präzise zu planen, was die Aufgabe spannend und gleichzeitig herausfordernd macht. „Wir arbeiten hier an einer Technologie, für die es keinen vorgezeichneten Masterplan gibt, fast alles ist Neuland“, sagt Birk.

Die Zukunft führend gestalten

„Es ist toll, als Entwickler so nah an der Praxis arbeiten zu können und damit das Leben vieler Menschen komfortabler und sicherer zu machen“, ergänzt Birk. Und Andreas Schulz sagt: „Unsere Arbeit hat direkten Einfluss auf den Alltag vieler Leute, das motiviert.

Es ist schön, bereits so früh im Berufsleben die Zukunft in führender Position mitgestalten zu dürfen.“ Und die nächste Aufgabe wartet bereits auf das Duo: die vierte Generation der Multifunktionskamera und mit ihr der nächste Schritt auf dem Weg zum autonomen Fahren.

Im Fokus

Matthias Birk und Andreas Schulz

Projektleiter Function & Algorithms, Video Perception, Cross-Domain Computing Solutions, Bosch

Wir erschaffen Innovationen. Das heißt, jeden Tag offen für jede Art von Veränderung zu sein.

Matthias Birk und Andreas Schulz machten ihren Abschluss am Karlsruher Institut für Technologie, KIT. Birk studierte Elektrotechnik mit Vertiefung Systems-on-a-Chip, Schulz Mathematik mit Nebenfach Informatik. Birk promovierte nach einem Praktikum beim Bosch Research and Technology Center in Palo Alto am KIT im Bereich beschleunigte medizinische Bildrekonstruktion mittels paralleler heterogener Hardware-Plattformen. Schulz entschied sich für eine Industriepromotion bei Bosch im Bereich Bildverarbeitung, direkt dort, wo er nun an der Zukunft des Fahrens arbeitet.